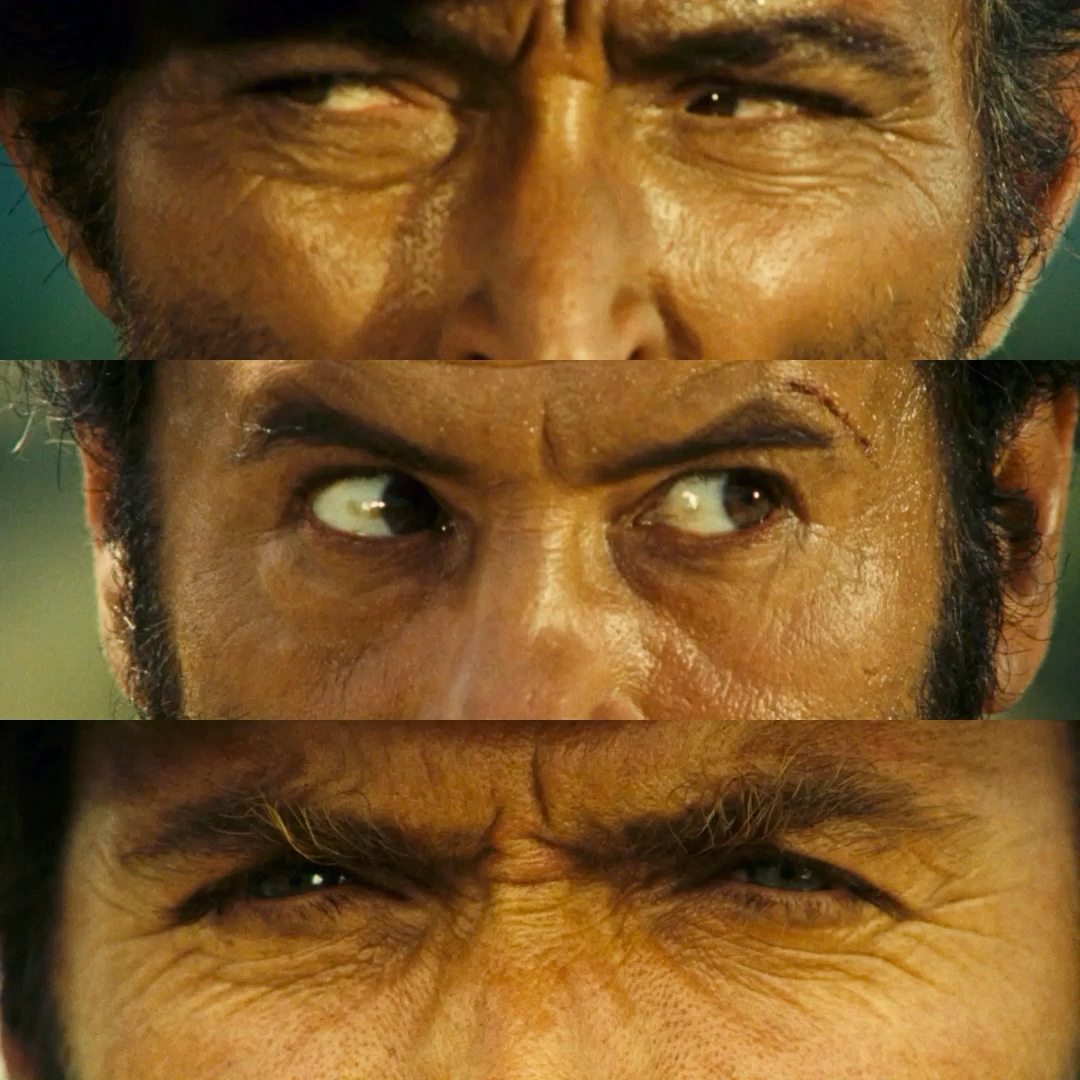

Le Bon, la Brute et le Truand

The good, the bad & the ugly

Il y a quelques années, j’ai été sollicité pour écrire un cours sur la stratégie d’entreprise pour des masters en école de commerce. C’était un module de 9h assez complet (fleurs sur moi), avec des exemples assez variés dans l’industrie (Airbus vs Boeing, automobile, défense), les services (restauration, nettoyage), agroalimentaire (grande distribution), etc. J’en parle parce que, c’est que j’augmenterai bien ces exemples de ce à quoi nous assistons en ce moment sur le marché de l’IA générative avec l’affrontement entre Meta, Microsoft et Google.

Transformers (pas le film qui provoque des crises d’épilepsie)

C’est peut être un peu galvaudé, mais les avancées des 10 dernières années en IA doivent beaucoup à Google, dont bon nombre de leurs produits ont été diffusés en open-source : Tensorflow, Word2Vec, JAX/FLAX, et… les Transformers. Ceux-ci ont révolutionné le traitement du langage naturel. Ce sont les Transformers qui ont permis BERT, le premier LLM de Google, et … GPT-1, oui oui le GPT comme dans ChatGPT.

Un des transformers

Google a parallèlement développé une grande infrastructure de Cloud public : Google Cloud Plateform, avec pour 2 concurrents principaux AWS et Azur. L’environnement GCP propose comme ses concurrents des solutions allant de simple hardware à des intégrations poussées sur les autres produits comme Google Workspace (gSuite), en concurrence directe avec Office365 de Crosoft.

Pourquoi je vous dis ça ? Ça va avoir son importance par la suite.

Pas très loin de chez Google, un laboratoire de recherche à but non lucratif, nommé OpenAI. OpenAI est créé par un ensemble de spécialistes du traitement en langage naturel, avec à son board, dès le lancement, Elon Musk. “OPEN” dans leur nom avait une vraie signification, puisque l’objectif était d’offrir au monde l’ensemble de leurs avancée. En 2018, OpenAI lance GPT1, leur premier LLM, ouvrant la voix aux autres versions. C’est en 2019 que celà devient interessant avec Microsoft qui injecte $1000000000000 (c’est beaucoup de brouzoufs) dans OpenAI avec en échange, la mise en place d’un partenariat privilégié autour des produits lancés. Premier signe de ce partenariat, l’ouverture des projets hébergés sur Github pour entrainer Copilot, le premier assistant IA de code, utilisant Codex, une version modifiée de GPT3.

Pendant ce temps là à Vera Cruz chez Facebook Meta, si la communication externe parle beaucoup du Metaverse, la société travaille beaucoup sur l’IA et a une culture très open-source : PyTorch, Bart, Roberta, Camembert, FastText, de nombreux outils de computer vision, etc. La liste est finalement assez longue, et ça peut surprendre, mais Facebook a fait profiter la communauté de beaucoup de ses avancées, je rappelle que la librairie la plus populaire au monde sur le développement frontend est React, créée par FB.

ChatGPT

Le 30 novembre 2022, OpenAI lance ChatGPT en fanfare. Si les modèles GPT2, Dall-e, GPT3 était déjà disponibles à des fins de tests / recherche, ChatGPT ouvre l’IA générative à Madame et Monsieur Tout-Le-Monde. 20h de TF1, articles enflammés dans les hebdomadaires, les cryptobros qui deviennent experts IA, les solopreneur copywriters au millions d’euros annuel (annoncés sur LinkedIn donc c’est vrai) qui deviennent experts / prompt engineer. L’IA est là. L’api de GPT3 s’ouvre, et on commence à voir apparaître les premiers “wrappers” et produits basés sur GPT. L’API et le chat tombent souvent sous le trafic, on peut facilement faire produire du contenu illicite (ah les premières recettes de Napalm fournies par ChatGPT…), bref, le monde ne sera plus comme avant et c’est grâce à OpenAI, la compagnie qui apporte l’IA à l’humanité.

La sortie de GPT4, 4 mois après, enfonce le clou, c’est toujours instable, c’est limité mais l’essentiel c’est que ça marche et c’est impressionnant, “tenez utilisez l’API pour tester des trucs, faites vous plaisir”. Et surtout CE N’EST PAS CHER.

“On travaille, bougez pas, ça arrive, accrochez vos ceintures”

Avec l’un des clients de Coddity (instant pub), vers avril/mai, nous explorions les use cases adressables avec l’API de GPT (alors 3.5). Utilisant un produit ML de Google cloud sur l’un de nos projets, nous avons été conviés à une conf pour parler des avancées en génératif côté Google. À ce moment, on parlait de Bard, mais sans avoir pu le tester. Donc naturellement, nous attendions la conf avec fébrilité, avec tout un tas de prompt à tester pour comparer les perfs. La conf démarre, notre account manager (très bon) nous déroule l’histoire de l’IA chez Google, les Transformers, Tensorflow, [slides], slides, slides… et une vidéo youtube de Bard. “Ouais bon, et sinon on peut tester ? Non ?” Ok on continue les slides, très belle présentation sur VertexAI, les jardins de modèles, les produits Google cloud intégrés avec de l’IA (GenAI App Builder Platform), l’intégration du génératif dans Workspace, etc. Vraiment canon. Mais pas accessible, pour le moment.

C’est là qu’on a compris (enfin je pense) : en fait Google n’était pas en retard, ils avaient juste eu une approche produit très très poussée, avec un grand nombre de cas d’usage adressés et une plateforme plug and play adaptée à tous les besoins.

J’imagine (enfin j’ai entendu dire) que pendant ce temps, les account managers Microsoft / Azure enchainaient les contact avec les DSI grands comptes pour pousser Azur GPT, CopilotX et Office 360 / Teams boostés par GPT, sans trop avoir besoin de forcer, puisque ChatGPT avait fait le travail.

Pendant que Google construisait une gamme de produits autour de l’IA générative et l’intégrait à son écosystème, OpenAI, et Microsoft derrière, ont réussi un coup de maitre en proposant un produit extrêmement simple (un chat) et une API, permettant aux gens de tester l’IA, et d’imaginer ce qu’il pouvait faire avec. La protection des données ? La confidentialité ? La fiabilité ? On verra après. La hype, la pub gratuite, le 20h de TF1 ont fait le reste. Maintenant dans la tête des gens IA = OpenAI, et quelles que soient les performances des produits Google ce sera le cas encore longtemps.

Et du côté de Mark Zuckerberg ?

Du côté de Meta, pas de changement de stratégie sur les produits IA. Meta a ouvert en Open Source leurs modèles, les différentes versions de Llama, avec une licence un peu particulière. En trois clics vous pouvez avoir votre Llama disponible sur votre Laptop, server ou instance AWS.

Serge

La question inévitable c’est pourquoi ? De ce que j’ai lu, l’entrainement de LLama a couté environ $20M, sans compter la R&D, la préparation des données d’entraînement, etc. $20M ça fait beaucoup de brouzoufs tout de même, y compris pour Facebook. Ok, il y a le narratif autour de l’open source, la force de la communauté, etc. Ce que je constate surtout, c’est que Meta n’est pas un cloud provider. Contrairement à Google et Microsoft, Meta ne vend pas à prix d’or un écosystème complet de produits logiciels, d’infra, etc. Donc leur capacité à gagner de l’argent avec leur modèle est limité. Ils ont la R&D, le cash, les compétences, pour produire des IA concurrentes d’OpenAI et Google, mais pas de moyens de distribution. J’y vois donc une façon élégante de couper l’herbe sous le pied des 2 autres. Avoir son propre Llama interne offre de nombreux avantages pour une société qui a les moyens / l’intérêt de l’utiliser : confidentialité des données, fine tuning, sécurité d’accès, etc. Une autre raison pourrait être la rapidité de diffusion et d’évolution de l’IA générative Open Source, et je vous renvoi à un mémo interne qui a fuité de chez Google : We Have No Moat qui date de mai dernier.

Je vous laisse choisir maintenant de qui est le Bon, la Brute et le Truand.

[ disclaimer ] LLama n’est pas vraiment open source, ils mettent à disposition un modèle avec une licence permettant l’utilisation commerciale, gratuitement, c’est-à-dire une boîte noire que l’on peut utiliser pour générer du texte. Mais on ne sait pas comment cette boîte a été faite, quelles sont les données ayant servies à sa conception, etc.

[ disclaimer 2 ] Je me suis concentré sur les IA génératives textuelles pour l’écriture de l’article, je n’ai pas eu le temps de creuser la génération d’image, qui doit être aussi passionnante avec Dall-e, Stable diffusion, Midjourney, et consort.