Un signe de plus

Light is right

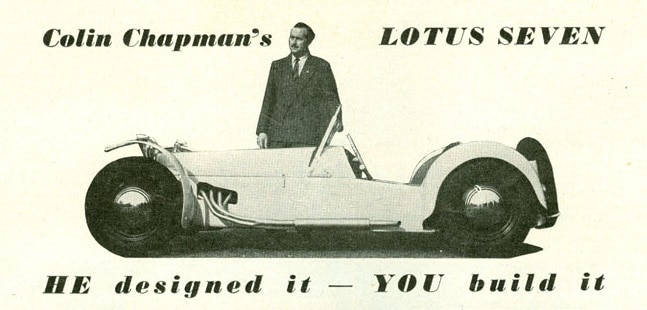

Connaissez vous Colin Chapman ? Si vous ne vous intéressez pas à l’histoire automobile, il ne vous dit sans doute rien. Même si vous avez déjà croisé ses création dans la rue ou au cinéma / TV.

Ce bel homme à moustache a créé la marque automobile de sport Lotus, avec un crédo : “Light is right”. 7, esprit, Elan, Elise, cett maxime s’est retrouvée dans la conception de ses véhicules : des voitures légères, bien moins puissantes que leurs concurrentes mais beaucoup plus efficaces, compansant leur manque de puissance par l’agileté.

Pourquoi je vous parle de Lotus ? Vous allez faire le lien.

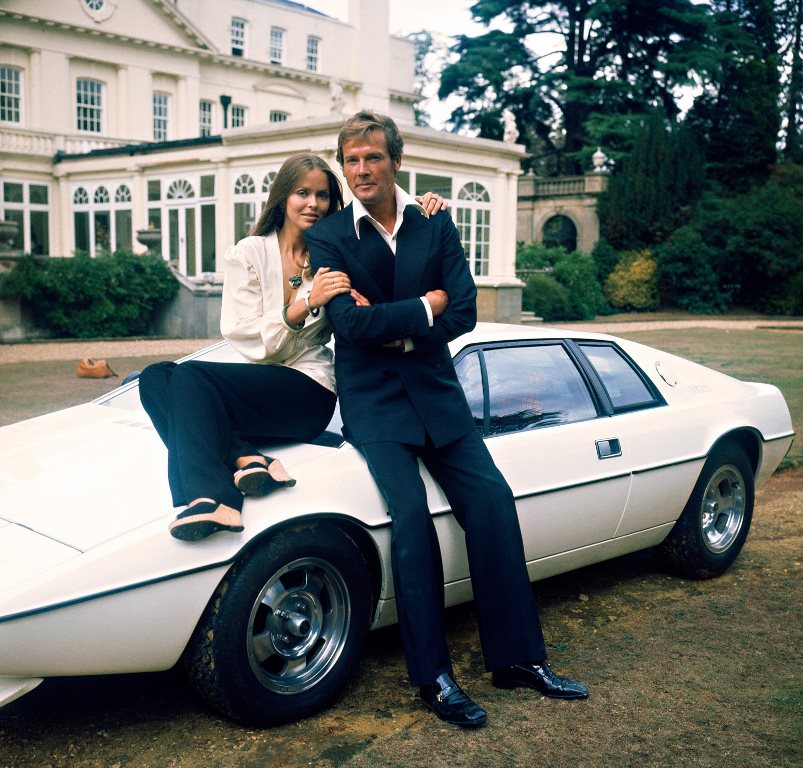

Barbara & Roger

En l’espace d’une semaine, 2 annonces particulières dans l’IA générative qui s’opposent dans l’approche :

💪 [le gros bras] L’université de technologie d’Abu Dhabi (Technology Innovation Institute) a officialisé la sortie de Falcon 18OB un LLM contenant plus de paramètres que GPT-3.5 (+5B), avec une licence permettant la commercialisation (restrictive cependant), ce qui en fait le LLM “open source” le plus puissant du moment. Le modèle a été entrainé sur 3.5T tokens, soit 2 600 000 000 000 mots (ça fait beaucoup). Un monstre qui a nécessité 7 millions d’heures d’entrainement (coutant certainement plusieurs dizaines de millions de dollars - environ $50M, AWS est content) et coutera assez cher à l’utilisation vu sa taille.

😏 [le malin] Microsoft research sort en “open source” phi-1.5 un petit modèle. Pourquoi petit ? vous allez pouvoir faire la comparaison avec ce qui est au dessus. 1.3B de paramètres entrainé sur 7 milliards token. Le modèle est plutot spécialisé sur la complétion de code informatique mais présente aussi avec des capacités de raisonnement. Ce modèle obtient un score de 50.6% à Human Eval(*) ce qui le place pas très loin de GPT4 (67%) ou wizardCoder (57%). Ce qui est assez incroyable vu la taille du modèle et la taille du set d’entrainement. Coté couts, on doit être sur quelques dizaines de milliers de dollars pour l’entrainement et la génération du dataset, sans compter évidemment les couts humain de R&D et de travail sur le dataset. FUN FACT : l’entrainement a du couter moins cher que la génération du dataset.

Comment ont ils fait ? Au lieu d’entrainer le modèle avec des données de qualité variable, ils ont travaillés à partir de codes disponibles sur Github et ont utilisés GPT4 et GPT3-5 pour construire un dataset de données synthétiques “de qualité”.

Pour simplifier grandement, un LLM a produit les données d’entrainement d’un autre LLM (ou aidé à produire).

Pourquoi c’est intéressant ? Comparer Falcon et Phil n’a pas vraiment de sens car on ne peut pas attendre de Phil les mêmes résultats sur du travail non spécialisé mais ça ouvre une nouvelle voie, celle de la disponibilité de petits modèles, spécialisés, pas cher à la création comme à l’utilisation et facilement fine tunables sur ses propres donneés.

Cette approche va (je pense) permettre à bas coûts d’explorer de nouvelles voies et de nouveaux use cases.

Je pense d’ailleurs que c’est l’avenir de l’IA générative, l’utilisation massive de petits modèles, fine tunés sur des datasets propriétaires, ne coutant que quelques milliers d’euros à entrainer et peu chers à l’utilisation. (Et c’est d’aillerus l’intuition que nous souhaitons explorer avec Coddity).

“Light is right” Colin

(*) “Human Eval” est une approche pour évaluer les performances des LLMs, créée par OpenAI qui permet de comparer les modèles entre eux.

DISCLAIMER Pourquoi je mets open source avec des "" => un modèle LLM vraiment open source mettrait à disposition de la communauté son code, la façon dont il a été construit et son dataset. Généralement, les LLMs opensource sont plutôt des boites noires disponibles sur Hugging Face avec des licences d’utilisation qui vous permettent de l’utiliser sur vos projets avec des restrictions d’usage ou commerciale.